Preizkusite VAŠE Podjetje v Minut

Ustvarite svoj račun in zaženite svojega AI chatbota v nekaj minutah. Popolnoma prilagodljiv, kodiranje ni potrebno - začnite takoj vključevati svoje stranke!

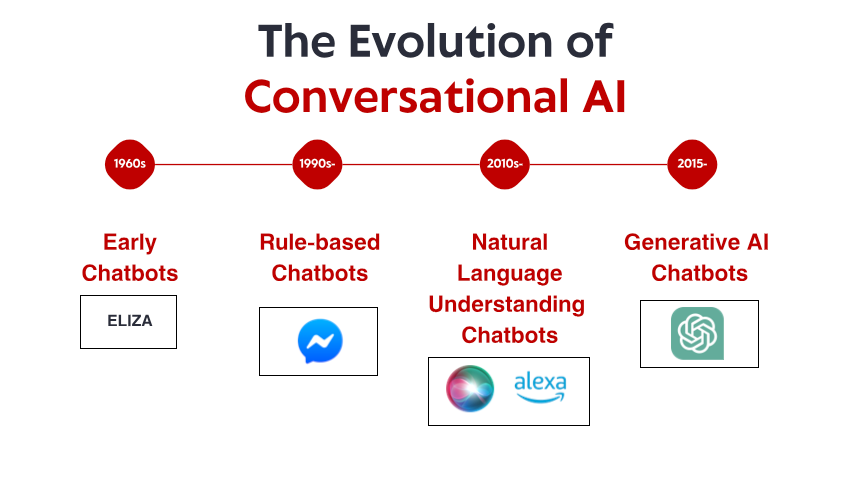

Skromni začetki: Zgodnji sistemi, ki temeljijo na pravilih

ELIZA ni bila izjemna zaradi svoje tehnične dovršenosti – po današnjih standardih je bil program neverjetno preprost. Prej pa zaradi globokega učinka, ki ga je imel na uporabnike. Čeprav so vedeli, da se pogovarjajo z računalniškim programom brez dejanskega razumevanja, so mnogi ljudje z ELIZO vzpostavili čustvene povezave in delili globoko osebne misli in občutke. Ta pojav, ki se je samemu Weizenbaumu zdel moteč, je razkril nekaj temeljnega o človeški psihologiji in naši pripravljenosti, da antropomorfiziramo celo najpreprostejše pogovorne vmesnike.

V sedemdesetih in osemdesetih letih prejšnjega stoletja so klepetalni roboti, ki temeljijo na pravilih, sledili ELIZINI predlogi z postopnimi izboljšavami. Programi, kot sta PARRY (ki je simuliral paranoičnega shizofrenika) in RACTER (ki je »avtor« knjige z naslovom »Policistova brada je napol zgrajena«), so ostali trdno znotraj paradigme, ki temelji na pravilih – z uporabo vnaprej določenih vzorcev, ujemanja ključnih besed in predlog odgovorov. Ti zgodnji sistemi so imeli hude omejitve. Pravzaprav niso mogli razumeti jezika, se učiti iz interakcij ali se prilagajati nepričakovanim vnosom. Njihovo znanje je bilo omejeno na pravila, ki so jih njihovi programerji izrecno opredelili. Ko so uporabniki neizogibno zašli izven teh meja, se je iluzija inteligence hitro razblinila in razkrila mehansko naravo pod njimi. Kljub tem omejitvam so ti pionirski sistemi postavili temelje, na katerih bo gradila vsa prihodnja pogovorna umetna inteligenca.

Revolucija znanja: Ekspertni sistemi in strukturirane informacije

Kljub temu je ta doba vzpostavila pomembne koncepte, ki so kasneje postali ključni za sodobno pogovorno umetno inteligenco: strukturirano predstavitev znanja, logično sklepanje in specializacija domene. Pripravljali so se temelji za premik paradigme, čeprav tehnologija še ni bila povsem tam.

Razumevanje naravnega jezika: preboj v računalniški lingvistiki

Ta premik je bil omogočen z več dejavniki: naraščajočo računalniško močjo, boljšimi algoritmi in, kar je ključno, razpoložljivostjo velikih besedilnih korpusov, ki jih je bilo mogoče analizirati za prepoznavanje jezikovnih vzorcev. Sistemi so začeli vključevati tehnike, kot so:

Označevanje besednih vrst: ugotavljanje, ali besede delujejo kot samostalniki, glagoli, pridevniki itd.

Prepoznavanje poimenovanih entitet: zaznavanje in razvrščanje lastnih imen (ljudi, organizacij, lokacij).

Analiza čustev: določanje čustvenega tona besedila.

Razčlenjevanje: analiza stavčne strukture za prepoznavanje slovničnih razmerij med besedami.

En opazen preboj je prišel z IBM-ovim Watsonom, ki je v kvizu Jeopardy! slavno premagal človeške prvake. leta 2011. Čeprav Watson ni bil zgolj pogovorni sistem, je pokazal izjemne sposobnosti razumevanja vprašanj v naravnem jeziku, iskanja po obsežnih zbirkah znanja in oblikovanja odgovorov – zmogljivosti, ki so se izkazale za bistvene za naslednjo generacijo klepetalnih robotov. Kmalu so sledile komercialne aplikacije. Applov Siri je bil predstavljen leta 2011 in je pogovorne vmesnike prinesel širši javnosti. Čeprav je bil Siri po današnjih standardih omejen, je predstavljal pomemben napredek pri omogočanju dostopa do pomočnikov umetne inteligence vsakodnevnim uporabnikom. Sledili so Microsoftova Cortana, Googleov Assistant in Amazonova Alexa, ki so vsaka od njih pospeševala najsodobnejšo tehnologijo v pogovorni umetni inteligenci, usmerjeni k potrošnikom. Kljub tem napredkom so se sistemi iz te dobe še vedno borili s kontekstom, sklepanjem na podlagi zdrave pameti in ustvarjanjem resnično naravno zvenečih odgovorov. Bili so bolj dovršeni kot njihovi predniki, ki so temeljili na pravilih, vendar so ostali v svojem razumevanju jezika in sveta bistveno omejeni.

Strojno učenje in podatkovno usmerjen pristop

V tem obdobju se je pojavil vzpon klasifikacije namenov in ekstrakcije entitet kot osrednjih komponent pogovorne arhitekture. Ko je uporabnik podal zahtevo, je sistem:

Klasificiral celoten namen (npr. rezervacija leta, preverjanje vremena, predvajanje glasbe)

Izluščil ustrezne entitete (npr. lokacije, datume, naslove pesmi)

Te je preslikal na določena dejanja ali odgovore

Facebookova (zdaj Meta) platforma Messenger je leta 2016 omogočila razvijalcem, da so ustvarili klepetalnice, ki so lahko dosegle milijone uporabnikov, kar je sprožilo val komercialnega zanimanja. Številna podjetja so hitela z uvedbo klepetalnih robotov, čeprav so bili rezultati mešani. Zgodnje komercialne implementacije so pogosto frustrirale uporabnike z omejenim razumevanjem in togimi poteki pogovorov.

V tem obdobju se je razvila tudi tehnična arhitektura pogovornih sistemov. Tipičen pristop je vključeval cevovod specializiranih komponent:

Samodejno prepoznavanje govora (za glasovne vmesnike)

Razumevanje naravnega jezika

Upravljanje dialoga

Generiranje naravnega jezika

Pretvorba besedila v govor (za glasovne vmesnike)

Vsako komponento je bilo mogoče optimizirati ločeno, kar je omogočilo postopne izboljšave. Vendar so te arhitekture cevovodov včasih trpele zaradi širjenja napak – napake v zgodnjih fazah so se kaskadno širile po sistemu.

Medtem ko je strojno učenje znatno izboljšalo zmogljivosti, so se sistemi še vedno borili z ohranjanjem konteksta med dolgimi pogovori, razumevanjem implicitnih informacij in ustvarjanjem resnično raznolikih in naravnih odzivov. Naslednji preboj bi zahteval bolj radikalen pristop.

Revolucija transformatorjev: modeli nevronskih jezikov

Pri pogovorni umetni inteligenci so se ti napredki prenesli v klepetalne robote, ki so lahko:

Vzdrževali koherentne pogovore skozi več korakov

Razumeli niansirana vprašanja brez izrecnega usposabljanja

Ustvarjali raznolike, kontekstualno ustrezne odgovore

Prilagajali svoj ton in slog uporabniku

Obvladovali dvoumnost in po potrebi razjasnili

Izdaja ChatGPT konec leta 2022 je te zmogljivosti prinesla v mainstream in v nekaj dneh po predstavitvi privabila več kot milijon uporabnikov. Nenadoma je imela širša javnost dostop do pogovorne umetne inteligence, ki se je zdela kvalitativno drugačna od vsega, kar je bilo prej – bolj prilagodljiva, bolj podkovana in bolj naravna v svojih interakcijah.

Hitro so sledile komercialne implementacije, podjetja pa so v svoje platforme za pomoč strankam, orodja za ustvarjanje vsebin in aplikacije za produktivnost vključila velike jezikovne modele. Hitro sprejetje je odražalo tako tehnološki preskok kot intuitiven vmesnik, ki so ga ti modeli zagotavljali – pogovor je navsezadnje najbolj naraven način komunikacije ljudi.

Preizkusite VAŠE Podjetje v Minut

Ustvarite svoj račun in zaženite svojega AI chatbota v nekaj minutah. Popolnoma prilagodljiv, kodiranje ni potrebno - začnite takoj vključevati svoje stranke!

Večmodalne zmogljivosti: Več kot le besedilni pogovori

Modeli vizualnega jezika, kot so DALL-E, Midjourney in Stable Diffusion, so pokazali sposobnost ustvarjanja slik iz besedilnih opisov, medtem ko so modeli, kot je GPT-4 z vizualnimi zmogljivostmi, lahko analizirali slike in o njih inteligentno razpravljali. To je odprlo nove možnosti za pogovorne vmesnike:

Boti za pomoč strankam, ki lahko analizirajo fotografije poškodovanih izdelkov

Nakupovalni asistenti, ki lahko prepoznajo artikle na slikah in najdejo podobne izdelke

Izobraževalna orodja, ki lahko razložijo diagrame in vizualne koncepte

Funkcije dostopnosti, ki lahko opišejo slike za slabovidne uporabnike

Tudi glasovne zmogljivosti so se močno razvile. Zgodnji govorni vmesniki, kot so sistemi IVR (interaktivni glasovni odziv), so bili znano frustrirajoči, omejeni na toge ukaze in strukture menijev. Sodobni glasovni asistenti lahko razumejo naravne govorne vzorce, upoštevajo različne naglase in govorne ovire ter se odzivajo z vse bolj naravno zvenečimi sintetiziranimi glasovi. Združitev teh zmogljivosti ustvarja resnično multimodalno pogovorno umetno inteligenco, ki lahko brezhibno preklaplja med različnimi načini komunikacije glede na kontekst in potrebe uporabnika. Uporabnik lahko začne z besedilnim vprašanjem o popravilu tiskalnika, pošlje fotografijo sporočila o napaki, prejme diagram z označenimi ustreznimi gumbi in nato preklopi na glasovna navodila, medtem ko so njegove roke zaposlene s popravilom. Ta multimodalni pristop ne predstavlja le tehničnega napredka, temveč temeljni premik k bolj naravni interakciji med človekom in računalnikom – srečanje z uporabniki v katerem koli načinu komunikacije, ki najbolje ustreza njihovemu trenutnemu kontekstu in potrebam.

Generiranje z razširjenim pridobivanjem: utemeljitev umetne inteligence na dejstvih

Retrieval-Augmented Generation (RAG) se je pojavil kot rešitev za te izzive. Namesto da bi se zanašali izključno na parametre, pridobljene med učenjem, sistemi RAG združujejo generativne sposobnosti jezikovnih modelov z mehanizmi za pridobivanje, ki lahko dostopajo do zunanjih virov znanja.

Tipična arhitektura RAG deluje takole:

Sistem prejme uporabniško poizvedbo

Išče v ustreznih bazah znanja informacije, ki so pomembne za poizvedbo

Poizvedbo in pridobljene informacije posreduje jezikovnemu modelu

Model ustvari odgovor, ki temelji na pridobljenih dejstvih

Ta pristop ponuja več prednosti:

Natančnejši, dejanski odgovori z utemeljitvijo generiranja na preverjenih informacijah

Možnost dostopa do posodobljenih informacij, ki presega omejitev učenja modela

Specializirano znanje iz virov, specifičnih za določeno področje, kot je dokumentacija podjetja

Preglednost in pripisovanje z navajanjem virov informacij

Za podjetja, ki uvajajo pogovorno umetno inteligenco, se je RAG izkazal za še posebej dragocenega za aplikacije za storitve za stranke. Bančni klepetalni robot lahko na primer dostopa do najnovejših dokumentov o politikah, informacij o računih in zapisov o transakcijah, da zagotovi natančne, prilagojene odgovore, ki bi bili nemogoči s samostojnim jezikovnim modelom.

Razvoj sistemov RAG se nadaljuje z izboljšavami natančnosti pridobivanja, bolj dovršenimi metodami za integracijo pridobljenih informacij z ustvarjenim besedilom in boljšimi mehanizmi za ocenjevanje zanesljivosti različnih virov informacij.

Model sodelovanja med človekom in umetno inteligenco: iskanje pravega ravnovesja

Umetna inteligenca obravnava rutinska, ponavljajoča se vprašanja, ki ne zahtevajo človeške presoje

Ljudje se osredotočajo na kompleksne primere, ki zahtevajo empatijo, etično razmišljanje ali ustvarjalno reševanje problemov

Sistem pozna svoje omejitve in po potrebi gladko preusmeri pomoč na človeške agente

Prehod med umetno inteligenco in človeško podporo je za uporabnika nemoten

Človeški agenti imajo celoten kontekst zgodovine pogovorov z umetno inteligenco

Umetna inteligenca se še naprej uči iz človeških posegov in postopoma širi svoje zmogljivosti

Ta pristop priznava, da pogovorna umetna inteligenca ne bi smela biti namenjena popolni nadomestitvi človeške interakcije, temveč njenemu dopolnjevanju – obravnavanju obsežnih, preprostih vprašanj, ki človeškim agentom porabljajo čas, hkrati pa zagotavlja, da kompleksna vprašanja dosežejo pravo človeško strokovno znanje. Izvajanje tega modela se razlikuje glede na panogo. V zdravstvu bi lahko klepetalni roboti z umetno inteligenco obravnavali načrtovanje terminov in osnovno testiranje simptomov, hkrati pa zagotavljali, da zdravniški nasveti prihajajo od usposobljenih strokovnjakov. V pravnih storitvah bi lahko umetna inteligenca pomagala pri pripravi dokumentov in raziskavah, medtem ko bi interpretacijo in strategijo prepustila odvetnikom. V storitvah za stranke lahko umetna inteligenca reši pogoste težave, kompleksne pa usmeri k specializiranim agentom. Z nadaljnjim razvojem zmogljivosti umetne inteligence se bo meja med tem, kar zahteva človeško sodelovanje, in tem, kar je mogoče avtomatizirati, premaknila, vendar temeljno načelo ostaja: učinkovita pogovorna umetna inteligenca bi morala izboljšati človeške zmogljivosti in jih ne bi zgolj nadomestiti.